Na czym potyka się adopcja rozwiązań AI? Na obietnicach bez pokrycia.

Inspiracją do dzisiejszego maila jest krótka interakcja na zamkniętym forum dotyczącym AI z Panią Joanną (imię zmienione, ale zrzuty ekranu konwersacji publikuję za zgodą autorki). Pani Joanna podzieliła się swoimi doświadczeniami z pracą z dużym dokumentem (400 stron) w interfejsie ChatGPT, które nie pokrywały się z mainstreamową komunikacją odnośnie tego, co potrafią modele językowe. Jej wnioski poniżej:

Niestety, nieporozumienia zaczynają się już na poziomie interfejsu ChatGPT. Fakt, że można załączyć plik do konwersacji (ikonka spinacza) sugeruje, że model “przeczyta” cały dokument.

Ale to nie jest prawda - nawet w przypadku krótkich dokumentów domyślnie włączy się system RAG, czyli algorytm, który potnie dokument na kawałki i spróbuje semantycznie odnaleźć pasujące fragmenty do bieżącego zapytania użytkownika. Czy użytkownik dowie się, które fragmenty z dokumentu zostały wzięte pod uwagę przy wygenerowaniu odpowiedzi? Oczywiście, że nie. Czy weźmie pod uwagę wszystkie, które znalazł? Też nie. Szczegółowy opis tutaj (to nie jest strona OpenAI - firma raczej nie spieszy się z tworzeniem dokumentacji dla użytkowników nietechnicznych).

Korzystanie ze stron internetowych ma taki sam efekt - dokumenty zostaną pocięte na kawałki (o ile w ogóle interfejs OpenAI będzie w stanie przeczytać ich tekst) i informacja, która pomoże użytkownikowi zinterpretować odpowiedź modelu znów nie zostanie wyświetlona.

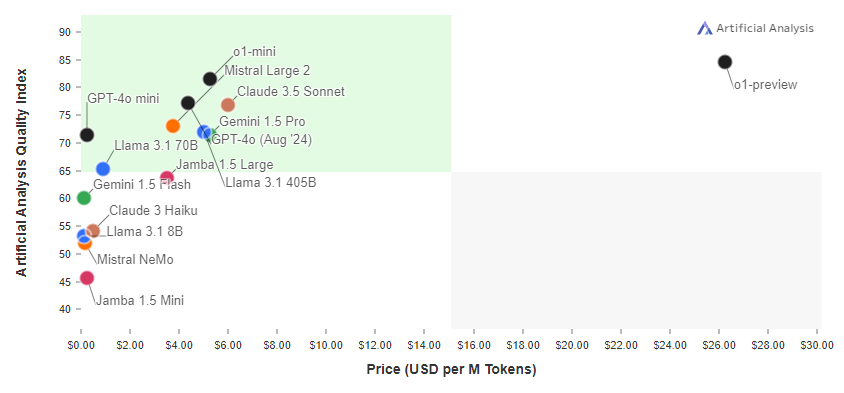

Kolejny problem to to, że jeśli dokument PDF zawiera elementy, które wyglądają na tekst a tekstem nie są (np. cytaty na osobnym tle, albo diagramy) lub w ogóle grafikę, to nie zostaną w ogóle odczytane lub zostaną odczytane z błędami. Problematyczne są zwłaszcza wykresy. ChatGPT 4o na pytanie o koszt miliona tokenów dla modelu Claude 3.5 Sonnet (na wykresie: $6) odpowiada: $10.50.

Jeśli dokument dotyczy w miarę popularnego tematu, to modele językowe braki w “przeczytanej informacji” uzupełnią spekulatywnie. Czyli inaczej, będą ściemniać, a będzie to wyglądało jakby “czytały” załączone dokumenty.

Kolejna kwestia: modele językowe mają ograniczenie na ilość informacji/słów, które są w stanie przetworzyć podczas generowania odpowiedzi - to okno kontekstowe. Okno czata w interfejsie ChatGPT ma własny limit na wielkość pojedynczej instrukcji (sporo mniejszy). Dlaczego? Bo założenie jest takie, że to jest czat (pytanie, odpowiedź, pytanie, odpowiedź, itd.), więc interfejs z góry zakłada, że nie może wykorzystać całego okna kontekstowego w pojedynczej interakcji (decyzja specjalistó UX). Co więcej, dla użytkownika nie jest jasne, że dla bardzo długich konwersacji okno kontekstowe będzie się przemieszczać, tj. będzie brać pod uwagę wyłącznie najnowsze interakcje i powoli zapominać te najstarsze. Wg różnych eksperymentów czat z modelem GPT4o może sięgać nawet 150 tys. słów (ok. 1.5x dostępne okno kontekstowe tego modelu), co oznacza, że pierwsze 30% konwersacji zostanie zignorowane pod koniec takiej interakcji. 400 stronicowy dokument Pani Joanny, nawet wrzucany kawałkami do takiej interakcji, i tak się prawdopodobnie nie zmieści w całości w oknie kontekstowym. Ale interfejs będzie sprawiał wrażenie, że mieści się cały.

Innym, niewinnym w porównaniu do poprzednich, “niedomówieniem” na stronie OpenAI jest wyświetlony “łańcuch myśli” (chain of thought) na stronie modelu o1. To nie jest odzwierciedlenie prawdziwej analizy, którą model symuluje zanim da odpowiedź. Prawdziwa jest ukryta. W dodatku OpenAI wysyła ostrzeżenia lub blokuje konta osobom, które próbują dociekać, jaki jest prawdziwy schemat postępowania, a nie ten wyświetlony w interfejsie ChatGPT. Rzućcie okiem na jeden z przykładów takiego bana na Twitterze/X.

Ot, ciekawostka.

Odpowiedź Pani Joanny na powyższe wyjaśnienia:

Moje dalsze rady dla Pani Joanny dotyczyły użycia modelu, który pozwala cały dokument wkleić wprost do interakcji (pozwala na to Workbench firmy Anthropic lub AI Studio od Google’a). Nie wiem, czy model poprawnie przeanalizuje długi i skomplikowany dokument, ale przynajmniej będzie wiadomo gdzie jest problem.

I doskonale rozumiem frustracje Pani Joanny. Mainstreamowa komunikacja (w tym także wielu “ekspertów”) bazuje na lśniących demo i łatwych przykładach. Jak sama Pani Joanna domyśla się już w powyższym komentarzu, wiele osób może mieć wrażenie, że model robi to, co sugeruje interfejs (czyta i analizuje całe dokumenty), bo sam dokument albo zawiera streszczenia, albo dotyczy tak popularnego tematu, że i bez dokumentów odpowiedź wygenerowana przez model byłaby taka sama.

W 2024 roku polskich firmach nietechnologicznych bardzo łatwo znaleźć kogoś, kto z narzędzia takiego jak ChatGPT (lub Perplexity, lub Copilot/Bing AI) korzysta dość regularnie do prostych zastosowań. Te same osoby mają za sobą doświadczenia analogiczne do Pani Joanny: frustracje, że model teoretycznie coś umie, a oni nie potrafią tego powtórzyć na własnych dokumentach. Czasem idą na szkolenie z inżynierii promptów, jakby to miało cokolwiek pomóc. I dlatego w badaniach “brak szkoleń” wychodzi jako główna bariera adopcji AI (omawiałem to badanie 2 miesiące temu), bo te dostępne nie rozwiązują pewnych problemów.

Czy w takiej firmie przyjmie się AI? Bardzo długo nie, bo z takim poziomem dezinformacji nt. realnych możliwości tej technologii decyzja o pilotażu będzie odsuwana w nieskończoność, bo “ten AI to taka zabawka”. Nie będzie chęci do eksperymentowania dalej, skoro pierwsze eksperymenty bazujące na lśniących demo bezkrytycznych entuzjastów AI się nie udały.

Wczoraj akurat miałem przyjemność prowadzić 6h warsztat dotyczący AI w firmie z branży rekrutacyjnej. Spędziłem ok. 1.5h wyjaśniając ograniczenia technologii, zanim w sesji interaktywnej przeszliśmy do możliwości jakie ona daje. Już w pierwszym przykładzie testów na prawdziwych dokumentach z tej firmy zobaczyliśmy przykład “halucynacji” (model zmyślił informację, której w dostarczonych informacjach nie było). Odpowiedzią było “aha” uczestników - zobaczyli coś, co obiecywałem, że się wydarzy, bo taka jest natura tej technologii. I szybko znaleźliśmy przykłady, gdzie spekulatywna sztuczna inteligencja może im pomóc, bo oczekiwania zostały urealnione. Mam wrażenie, że całe spotkanie było dla nich inspirujące na tyle, że rozważą na poważnie wdrożenie AI chociażby w bardzo wąskim zakresie (czas pokaże, jestem ciekaw).

Ale jak mainstream AI-owy będzie cały czas operował na lśniących demo, adresował komunikację głównie do osób technicznych, albo używał argumentów “u mnie działa”, to adopcji tej technologii poza branżą IT nie doczekamy się w żadnym przewidywalnym czasie. OpenAI dosłownie kilka dni temu uruchomił inicjatywę “OpenAI Academy” aby katalizować wzrost gospodarczy dzięki sztucznej inteligencji. Adresaci: programiści. Znowu.

Alternatywa? Dość oczywista. Zostawić dema w komunikacji, przerzucić się na twarde studia przypadków biznesowych wdrożeń AI. Mamy ich w Polsce bardzo mało.

Ciekawe niusy

Firma Hume, która specjalizuje się w analizie emocji w głosie, opublikowała nowy model głosowy EVI2 (możecie z nim porozmawiać przez przeglądarkę po angielsku). Tego rodzaju model będzie miał potencjalnie pod górkę w Europie ze względu na AI Act (m.in. dlatego Europa nie dostała jeszcze zaawansowanego trybu głosowego w ChatGPT, podczas gdy reszta świata już go ma od wczoraj), ale warto potestować, bo pod pewnymi ograniczeniami funkcjonalność głosowych asystentów zawita do nas prędzej czy później.