Czym się różnią modele predykcyjne od generatywnych?

Dwóch naukowców z Uniwersytetu w Princeton napisało książkę “AI Snake Oil” (pojawi się w księgarniach 24. września 2024, można przeczytać wstęp online), w której jest fantastyczna metafora opisująca obecny stan komunikacji wokół AI.

Wyobraźcie sobie, że ze słownika znikają wszystkie słowa precyzyjnie wskazujące na rodzaj pojazdu, a zostaje tylko “pojazd”. Nie mamy słów “samochód”, “rakieta”, “hulajnoga”, “wrotki”, “samolot”. Jest “pojazd”.

Wyobraźcie sobie bałagan w komunikacji. Ktoś sprzedaje paliwo do pojazdów. Inny ładowarki elektryczne do pojazdów. Ktoś inny pisze o zaletach pojazdów napędzanych siłą mięśni. Ktoś się chwali, że ma pojazdy, które pozwalają dotrzeć z Warszawy do Barcelony w 4 godziny, a Wy dzwonicie do lokalnego dealera samocho… znaczy się pojazdów i pytacie, kiedy szybsze modele będą w sprzedaży.

Tak właśnie wygląda komunikacja wokół sztucznej inteligencji. Wszystko jest “AI” i osoby spoza branży technologicznej nie mają szans połapać się, co jest tak naprawdę czym.

Więc dzisiaj spróbujemy to wyjaśnić, rozdzielając grubą kreską “nową sztuczną inteligencję” (GenAI czyli modele spekulatywne/generatywne, o których piszę w tym newsletterze) od “starej sztucznej inteligencji” (modele predykcyjne, których pewnie używacie nieświadomie w wielu aplikacjach).

Elastyczność i zakres zastosowań

Stare AI:

Zazwyczaj wąsko wyspecjalizowane do konkretnych zadań

Wymaga tworzenia osobnych modeli dla różnych zastosowań

Trudniejsze do adaptacji do nowych scenariuszy

GenAI:

Znacznie bardziej wszechstronne i elastyczne

Jeden model może obsługiwać wiele różnych zadań

Łatwiejsze do dostosowania do nowych zastosowań poprzez odpowiednie instrukcje

Podstawowy powód, dla którego trwa właśnie boom na sztuczną inteligencję, to elastyczność nowych rozwiązań. Chcesz napisać notatkę na bloga firmowego, przeanalizować dokument prawny, napisać kod źródłowy aplikacji - wszystko obsługuje jeden model.

Sposób interakcji

Stare AI:

Często wymaga specjalistycznego interfejsu lub znajomości programowania

Interakcja oparta głównie na wprowadzaniu danych i otrzymywaniu wyników

GenAI:

Umożliwia interakcję w języku naturalnym

Pozwala na prowadzenie dialogu i doprecyzowywanie poleceń

Drugi powód boomu na AI - interakcja w języku naturalnym, co dramatycznie obniża próg efektywnego korzystania z tej technologii.

Rodzaj wyników

Stare AI:

Zwykle dostarcza konkretne predykcje lub klasyfikacje

Wyniki często w formie liczbowej lub kategorycznej

Predykcje zazwyczaj są deterministyczne (jak puścimy predykcję 1000x to 1000x dostaniemy taki sam wynik)

GenAI:

Generuje różnorodne formy treści (tekst, kod, obrazy)

Może tworzyć kreatywne i oryginalne rozwiązania

Z definicji niedeterministyczne (jak się zapytacie 100 razy o stolicę Francji, to modele GenAI raczej nie odpowiedzą identycznie, choć pewnie 100 razy Paryż będzie w odpowiedzi)

Bardzo ważnym elementem pracy z “nową sztuczną inteligencją” jest rozumienie, że ma niedeterministyczny (lub, jak wolę mówić “spekulatywny”) charakter. Trudno sobie wyobrazić wdrożenie takiej technologii bez nadzoru człowieka, co dla odmiany możliwe było w systemach o architekturze deterministycznej.

Wymagania dotyczące danych

Stare AI:

Wymaga dużych, dobrze ustrukturyzowanych zbiorów danych do treningu

Często potrzebuje danych specyficznych dla danej firmy lub branży

GenAI:

Może korzystać z ogólnej wiedzy zdobytej podczas wstępnego treningu

Łatwiejsze do dostosowania do specyfiki firmy bez konieczności trenowania od zera

Podstawowym źródłem danych dla nowych modeli AI są dane niestrukturyzowane - tekst, obraz, wideo. Podstawowym źródłem danych dla modeli predykcyjnych są tabelki z danymi (i oby zawierały dane poprawne, wyczyszczone i dobrze opisane).

Transparentność i wyjaśnialność

Stare AI:

Często oferuje większą transparentność procesu decyzyjnego

Łatwiejsze do audytu i weryfikacji

GenAI:

Proces decyzyjny może być mniej przejrzysty (problem "czarnej skrzynki")

Wymaga dodatkowych narzędzi i technik do interpretacji wyników

Cały obszar “inżynierii promptów” wziął się z faktu, że nie ma możliwości z góry przewidzieć (wyjaśnić) jak różne instrukcje będą wpływać na charakter zwracanych treści. Sam rozmiar modeli nowej generacji utrudnia również analizę.

Szybkość wdrożenia

Stare AI:

Często wymaga długiego procesu zbierania danych i trenowania modelu

Wdrożenie może trwać miesiące lub nawet lata

GenAI:

Możliwe szybsze wdrożenie dzięki wykorzystaniu gotowych, wstępnie wytrenowanych modeli

Czas adaptacji do specyficznych potrzeb firmy znacznie krótszy

To jest strasznie ważny element wdrożeń w firmach nietechnologicznych. W zasadzie wystarczy wykupienie licencji biznesowej na platformie OpenAI dla swoich pracowników i już - wdrożenie od strony technicznej zakończone.

Koszty i zasoby

Stare AI:

Może wymagać znacznych inwestycji w infrastrukturę i specjalistyczne oprogramowanie

Często potrzebuje dedykowanego zespołu specjalistów od data science

GenAI:

Możliwość korzystania z modeli w chmurze, co redukuje koszty infrastruktury

Mniejsze zapotrzebowanie na specjalistów AI, większy nacisk na umiejętność formułowania odpowiednich instrukcji

To nie jest tak, że wdrożenie GenAI nie wymaga kompetencji, ale na pewno kompetencje do używania modeli generatywnych są zazwyczaj łatwiej dostępne.

Kreatywność i innowacyjność

Stare AI:

Ograniczona zdolność do generowania nowych, kreatywnych rozwiązań

Skupia się głównie na analizie istniejących wzorców

GenAI:

Może generować innowacyjne pomysły i rozwiązania

Wspiera procesy kreatywne w firmie

Modele predykcyjne z założenia analizują istniejące wzorce. Modele generatywne z założenia tworzą interpolacje pomiędzy istniejącymi wzorcami. Inna zasada działania GenAI oznacza możliwość stosowania w procesach kreatywnych.

Co jest takie samo?

Integracja z istniejącymi procesami biznesowymi w firmie przebiega podobnie:

Stare AI i nowe AI:

Często wymaga znacznych zmian w istniejących procesach biznesowych

Trudno zintegrować z istniejącymi systemami IT, interfejsy albo nie istnieją, albo są trudne w obsłudze

Ze względu na wielomodalność GenAI (obsługę np. obrazów i tekstu przez ten sam model) trwają eksperymenty, które być może ułatwią integrację z innymi systemami, ale jak na razie uznajmy, że jest to równie upierdliwe, co w przypadku modeli predykcyjnych.

Podsumowanie

Parę miesięcy temu zżymałem się na EY, bo w raporcie, który twierdził “62% polskich firm wdraża, lub wdrożyło AI” ewidentnie do jednego worka wrzucili narzędzia oparte o modele predykcyjne (np. Grammarly, czy mapy Google) i narzędzia oparte o modele generatywne (np. ChatGPT).

Nie mylmy jednego z drugim.

GenAI oferuje większą elastyczność, łatwość użycia i potencjał innowacyjny w porównaniu do tradycyjnych modeli predykcyjnych. Jednak w niektórych przypadkach tradycyjne modele AI mogą nadal być preferowane, szczególnie tam, gdzie wymagana jest wysoka precyzja i powtarzalność procesu decyzyjnego.

Dla firm nietechnologicznych, spekulatywna sztuczna inteligencja oferuje możliwość wdrożenia w niektórych procesach technologii AI, której bez dedykowanego działu IT i mnóstwa pieniędzy na R&D nie byliby w stanie wdrożyć kilka lat temu. O to chodzi w tym całym boomie na AI.

Ciekawe niusy

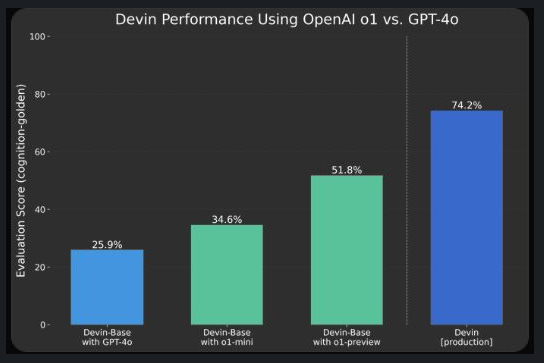

Firma OpenAI udostępniła o1, model językowy, który trenowany jest (mamy dostęp do wersji "preview", wersja produkcyjna wciąż jest w treningu) pod kątem wnioskowania logicznego. W wielu benchmarkach ma podobne "kompetencje" co GPT-4o, ale popatrzcie na różnicę (wykres), którą raportują twórcy Devina, jednego z narzędzi do wspomagania programowania.

Prawnicy za oceanem pieją z zachwytu - podobno w analizie tekstów prawnych bije poprzednika na głowę.

Z moich własnych obserwacji i testów: o1 odpowiedział poprawnie na wszystkie pytania, które projektowałem dla OpenAI w obszarze biologii molekularnej i strukturalnej a z którymi sobie nie radził GPT-4o. Radzi sobie również fantastycznie z analizą publikacji naukowych.

Większość użytkowników "czata" od OpenAI może nie zauważyć różnicy, bo w wielu zastosowaniach o1 nie jest lepszy niż rodzina GPT-4 (a np. w zadaniach kreatywnych wydaje mi się wyraźnie gorszy). W zastosowaniach wymagających mocnych kompetencji wnioskowania logicznego (a takich nie ma zbyt wiele), radzi sobie dużo lepiej.

Ponadto w wielu komentarzach ludzi wewnątrz bańki AI o1 jawi się jako ekspert-menadżer - model, który będzie służył do wygenerowania szczegółowego planu wykonania zadania, oraz który będzie weryfikował jego wykonanie. Natomiast poszczególne kroki wykonają modele szybsze i tańsze. Wydaje mi się, że ten scenariusz jest całkiem prawdopodobny, ale na skuteczne integracje i dobrą operacjonalizację poczekamy pewnie ładnych parę tygodni, jeśli nie miesięcy.

Tak czy siak, ciekawy (i specjalistyczny) model.