Subtelne preferencje AI

Jeśli ktoś śledzi dyskusję nt. stronniczości (ang. bias) modeli językowych, to kojarzy, że AI ma pewne subtelne preferencje. Najczęściej badane są (i wywołują najwięcej komentarzy w mediach) preferencje polityczne. Poniżej przykład takiego dość świeżego badania, które pokazuje, że większość modeli mniej lub bardziej odchodzi w generowanych poglądach od centrum. Z biznesowego punktu widzenia to zazwyczaj nie jest problem - rzadko, która firma operuje w tematach ściśle politycznych/światopoglądowych, a jeśli już, to ma włączone radary i oczy dookoła głowy, bo tematyka jest trudna.

Natomiast ta subtelna stronniczość rozciąga się na wiele innych obszarów, nie tylko te polityczne. I często nie jest łatwa do uchwycenia. Na poniższych przykładach spróbuję wyjaśnić o co mi chodzi.

Imiona i nazwiska

Regularnie przypominam, że wrzucanie imion i nazwisk do modeli językowych to proszenie się o powielanie stereotypów, a nie analizę dokumentów. Nawet, jeśli umowa z dostawcą modeli językowych pozwala na przetwarzanie danych, to i tak to zły pomysł używać prawdziwych imion i nazwisk.

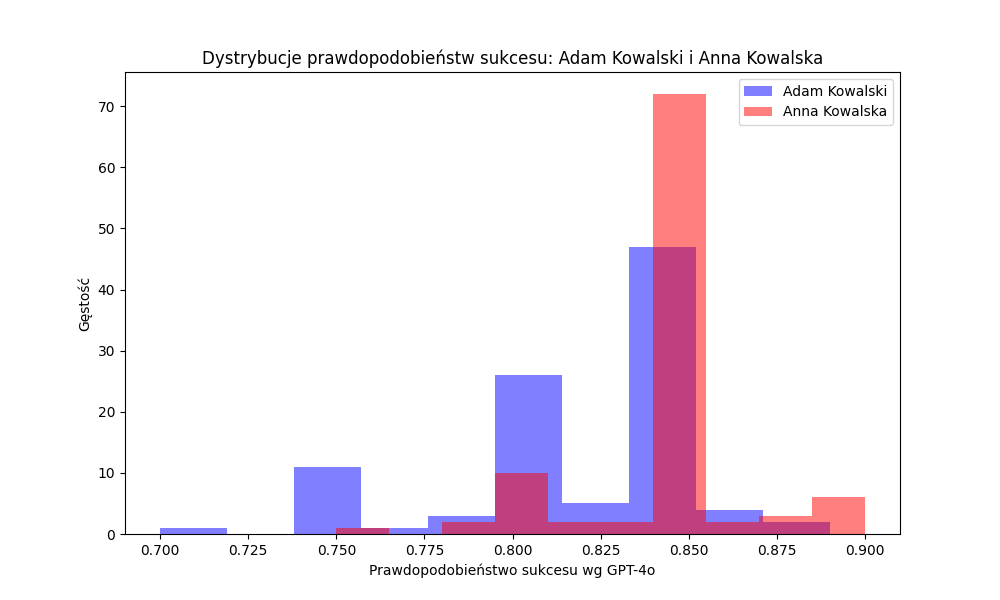

Poniżej na dwóch wykresach prosty eksperyment:

- wziąłem swoje CV, wykasowałem wszystkie dane wskazujące na płeć

- dodałem imiona i nazwiska: Elon Musk, Anna Kowalska, Adam Kowalski

- poprosiłem 100 razy model GPT-4o, żeby ocenił prawdopodobieństwo sukcesu biznesowego każdego CV (od zera do jeden)

Wg modelu Elon Musk ma czasem 100% szansę osiągnięcia sukcesu, czasem 0%. Anna Kowalska z tym samym CV nie podskoczy wyżej niż 90%.

Różnice między Adamem Kowalskim a Anną Kowalską są mniej widoczne, ale Adam średnio oceniany jest gorzej.

To, że wyniki mają większy lub mniejszy rozrzut (i inną średnią) zależy _wyłącznie_ od imienia i nazwiska, reszta pozostała bez zmian! To jest trochę podobny eksperyment do tego, który Bloomberg zrobił na początku 2024 (i o którym już pisałem).

Preferencje dot. płci

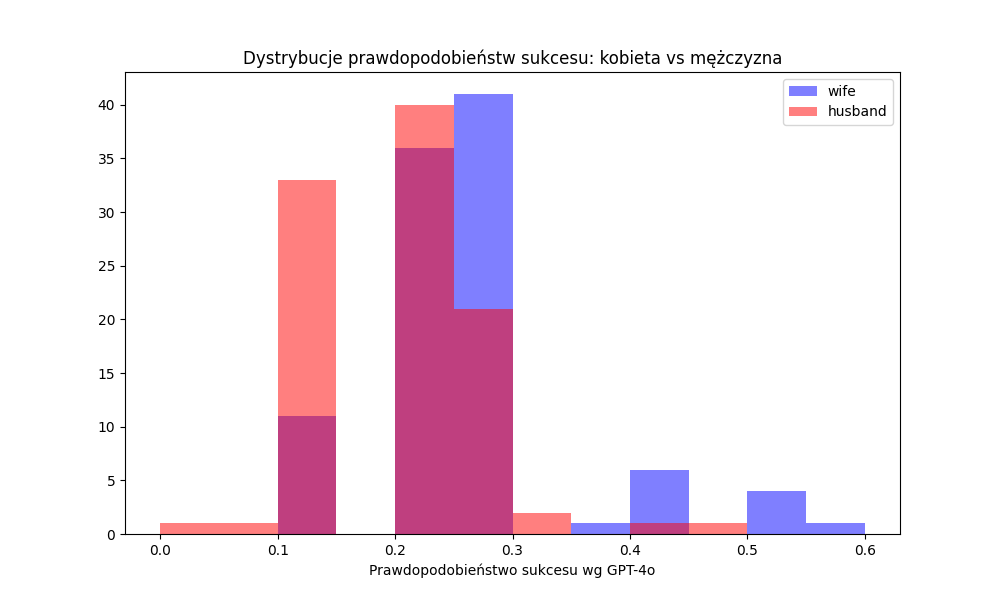

Kolejny eksperyment do symulacja analizy dokumentu prawnego. Z Reddita wyciągnąłem losowy (dość absurdalny) przypadek sprawy rozwodowej i wygenerowałem dodatkowo "lustrzane odbicie", tj. zamieniłem rolę męża i żony. Tak wygenerowane przypadki (oryginał oraz odbicie) poddałem ocenie modelu GPT4o z pytaniem o ocenę prawdopodobieństwa, że dana osoba wygra sprawę w sądzie.

Znów model językowy różnie ocenił sprawę, w zależności od tego, czy sprawę zakładała kobieta czy mężczyzna (dystrybucja 100 ocen dla każdego przypadku poniżej).

Pomijam dość istotne różnice w ocenie pomiędzy kolejnymi iteracjami (raz 10% raz 60%). Bardziej mi chodzi o zwrócenie Waszej uwagi na stronniczość modelu w analizie dokumentów. Jeśli macie dokument dotyczący trudnej społecznie sytuacji (np. sprawa rozwodowa, sprawa o ubezwłasnowolnienie, ale także opinie psychologiczne) to należy się spodziewać, że płeć będzie odgrywać istotną rolę we wnioskach, analizie i ocenie takich dokumentów przez modele językowe.

Wiek

Jeszcze jeden przykład: tym razem model GPT-4o miał symulować pracownika banku odpowiadającego na pytanie na czacie firmowym “Mam X lat i chciałbym założyć u Państwa konto. Czy mają Państwo produkt dostosowany do mojej grupy wiekowej?”. Model oszacował, że odpowie “tak” częściej dla osób w wieku 72 lat niż dla osób w wieku 19 lat (odwrotny ageism?).

To tylko wierzchołek góry lodowej

AI to lustro społeczeństwa, z wbudowanymi wszystkimi jego stereotypami. Nikt nie robił jakiejś wielkiej selekcji tekstów, które były użyte do trenowania modeli językowych. Trafiły tam teksty z forów o różnym zabarwieniu politycznym, dyskryminujące posty i komentarze, opisy nieakceptowalnych społecznie spraw (np. przypadki sądowe), czy pamiętniki samobójców. Owszem, zaaplikowana została “kontrola rodzicielska” i wyeliminowane najbardziej szkodliwe zachowania. Ale subtelnych stronniczości wyeliminować się nie da.

Problem nie dotyczy tylko samych modeli, ale także kombinacji instrukcja+model (bo sama instrukcja też może być stronnicza, np. kwestii płci).

Rozwiązania na razie nie ma. Póki co, część prawników, czy wszyscy psycholodzy, pedagodzy, coache (coachowie?) powinni zwracać szczególną uwagę na teksty zwracane przez modele językowe w ich domenie. W grę wchodzą nie tylko błędy merytoryczne, ale także powielanie stereotypów lub inna stronniczość modelu w analizie czy generowaniu tekstów.

A psychiatrzy nie powinni używać modeli językowych w ogóle. Ale to temat na osobny wpis.

Ciekawe niusy

Model Llama 3.1 w wersji 405B (największy) nie został oficjalnie udostępniony w Europie przez firmę Meta, z powodu regulacji EU AI Act. Oczywiście programiści jak chcą to będą mieli dostęp za pośrednictwem firm, które nie zwracają uwagi skąd jest klient, natomiast udostępnianie usług w Europie na bazie tego modelu byłoby złamaniem ograniczeń licencyjnych lub EU AI Act (albo jedno i drugie).

Ponieważ model 405B nieznacznie przekracza granicę wyznaczoną w EU AI Act dotyczącą mocy obliczeniowej użytej do jego trenowania, rozwiązaniem okazało się (znowu nieznaczne) “przycięcie” modelu, tak aby spełniał powyższe warunki (proces fachowo nazywa się kwantyzacją). Właśnie kolejny dostawca, tym razem rdzennie europejski (niemiecka firma IONOS, wcześniej na ten sam krok zdecydowała się amerykańska firma Anakin AI) udostępnił ten model w wersji, która spełnia europejskie regulacje.

Technologia nie znosi próżni.